0 引言

1 图像分割方法与改进

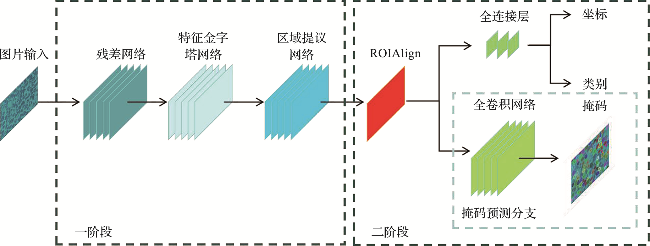

1.1 Mask R-CNN算法

1.2 Mask R-CNN模型的改进方案

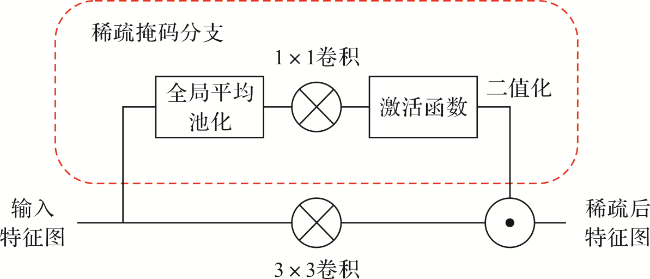

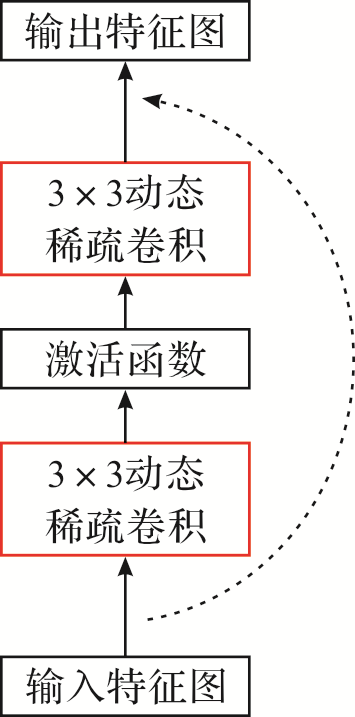

1.2.1 卷积模块优化

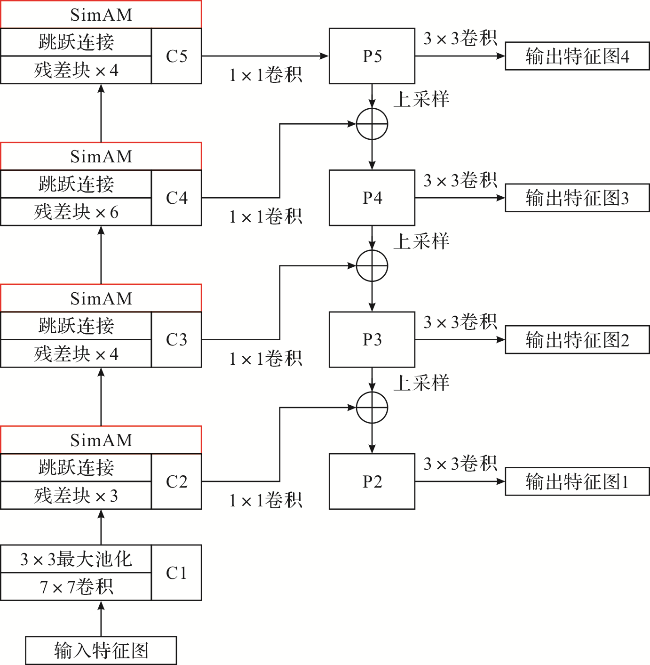

1.2.2 集成注意力模块优化

2 图像来源、预处理与数据集构建

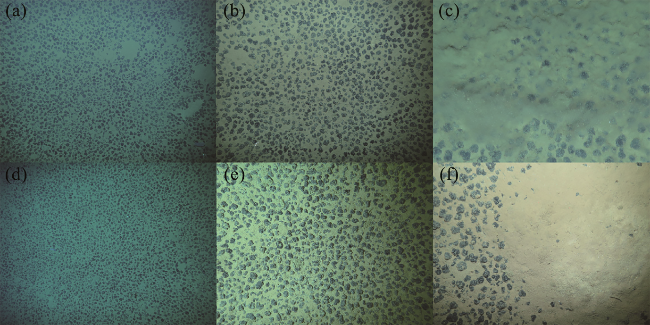

2.1 图像来源

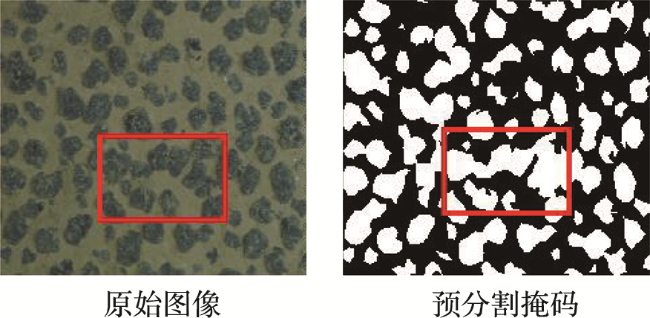

2.2 图像分割流程

2.3 图像掩码标注

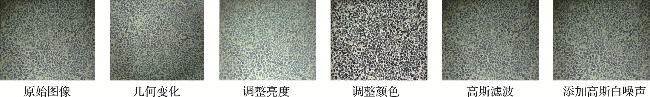

2.4 图像增强

2.5 训练集和测试集的图件数量

2.6 评价指标

3 模型测试结果

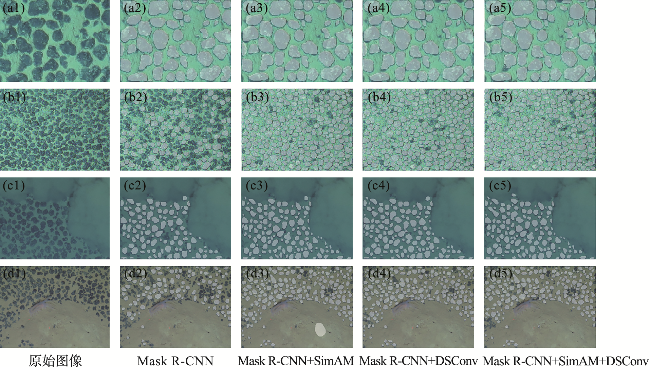

3.1 图像分割结果

表1 不同模型的测试结果评价Tab.1 Evaluation of test results for different models |

| 模型 | 准确 率/% | 精确 度/% | 召回 率/% | 交并 比/% |

|---|---|---|---|---|

| Mask R-CNN | 88.2 | 72.5 | 68.3 | 62.1 |

| Mask R-CNN+SimAM | 89.7 | 75.1 | 71.8 | 65.3 |

| Mask R-CNN+DSConv | 91.2 | 77.6 | 74.2 | 68.7 |

| Mask R-CNN+SimAM+DSConv | 91.5 | 78.0 | 75.1 | 69.4 |

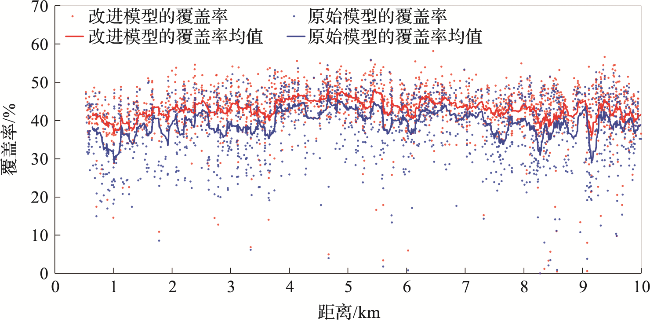

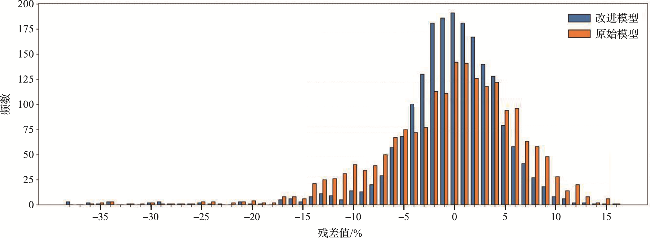

3.2 不同模型平均精度的比较

表2 不同模型的平均精度Tab.2 Average precision of different models |

| 模型 | AP/% | AP50/% | AP75/% | APs/% | APm/% | APl/% |

|---|---|---|---|---|---|---|

| Mask R-CNN | 58.84 | 84.32 | 69.61 | 58.82 | 66.28 | 37.42 |

| Mask R-CNN+SimAM | 61.59 | 85.49 | 72.85 | 61.33 | 72.47 | 46.07 |

| Mask R-CNN+DSConv | 64.07 | 86.76 | 76.31 | 64.08 | 72.87 | 47.06 |

| Mask R-CNN+SimAM+DSConv | 64.49 | 86.78 | 76.49 | 64.50 | 73.01 | 47.79 |